一篇論文指出,對機器人進行監管是極為困難的,而跟著人工智能的進一步廣泛,這也將成為一種越來越大的社會疑問。

為何機器人和人工智能將會難與管控?詳細要素有三個:

疑問之一:機器人和人工智能的多元性

關于在人工智能監管方面我們正在面臨的疑問,“隨機暗網購物者”的出現便是一個例子。

2014年,一組來自瑞士的藝術家構建了一個人工智能,他們給了這個人工智能每周100比特幣的核算,并對其進行編程,使得人工智能能夠在Agora(一個暗網上的在線商場,購物者能夠在上面收購到毒品以及其他一些違禁品)上隨機收購產品。

終究,這個被命名為“隨機暗網購物者”的人工智能買到了搖頭丸、匈牙利護照、冒牌迪賽牛仔褲、帶有蔭蔽攝像頭的棒球帽、開了洞能夠存放現金的雪碧罐、卷煙、耐克運動鞋以及一套指環王電子書……

因為不合法收購做法,瑞士差人起先沒收了這個機器人以及它所收購的物品,但后來又把東西還了回去(除了毒品)——而那些對此事負有責任的藝術家則并沒有遭到指控。

在這個案例中,雖然機器人有一個特定的目的,但構成其不合法做法的初衷卻是無害且偶爾的,因此警方沒有提出指控。

但不難想象,日后可能會有人帶著更為不光彩的主意,運用人工智能做一樣的作業。

這便是疑問地點。“人工智能難以預測和多元化的特征讓有關的法則編纂變得更為凌亂,假設管得太寬,很可能會無形之中阻撓立異的步伐;而假設管得不可,極為有限的維護又會失掉意義。”研究者們寫道。

疑問之二:透明度

運用神經網絡來創建人工智能能夠讓它非常好、更快地學習,但這么做意味著,你將不會理解人工智能為何做出這些作業。

如今,為了讓人工智能能夠完結相似圖像分析這種凌亂使命,運用神經網絡是一種非常成功的戰略——可是,這種成功卻讓對人工智能做法的監管變得更為困難,因為這種“黑箱”正在越來越盛行。

假設你不能看清“隨機暗網購物者”在做的終究是什么作業,那么判定其是不是有害就變得簡直不可能了。

疑問之三:結構

“不管包括在內的硬件、軟件和數據怎樣混合在一起,關于公平性、透明度、可解說性和責任承擔方面的關心都是對等的,它們起源一樣,也應該被一起處理。”研究者們說。

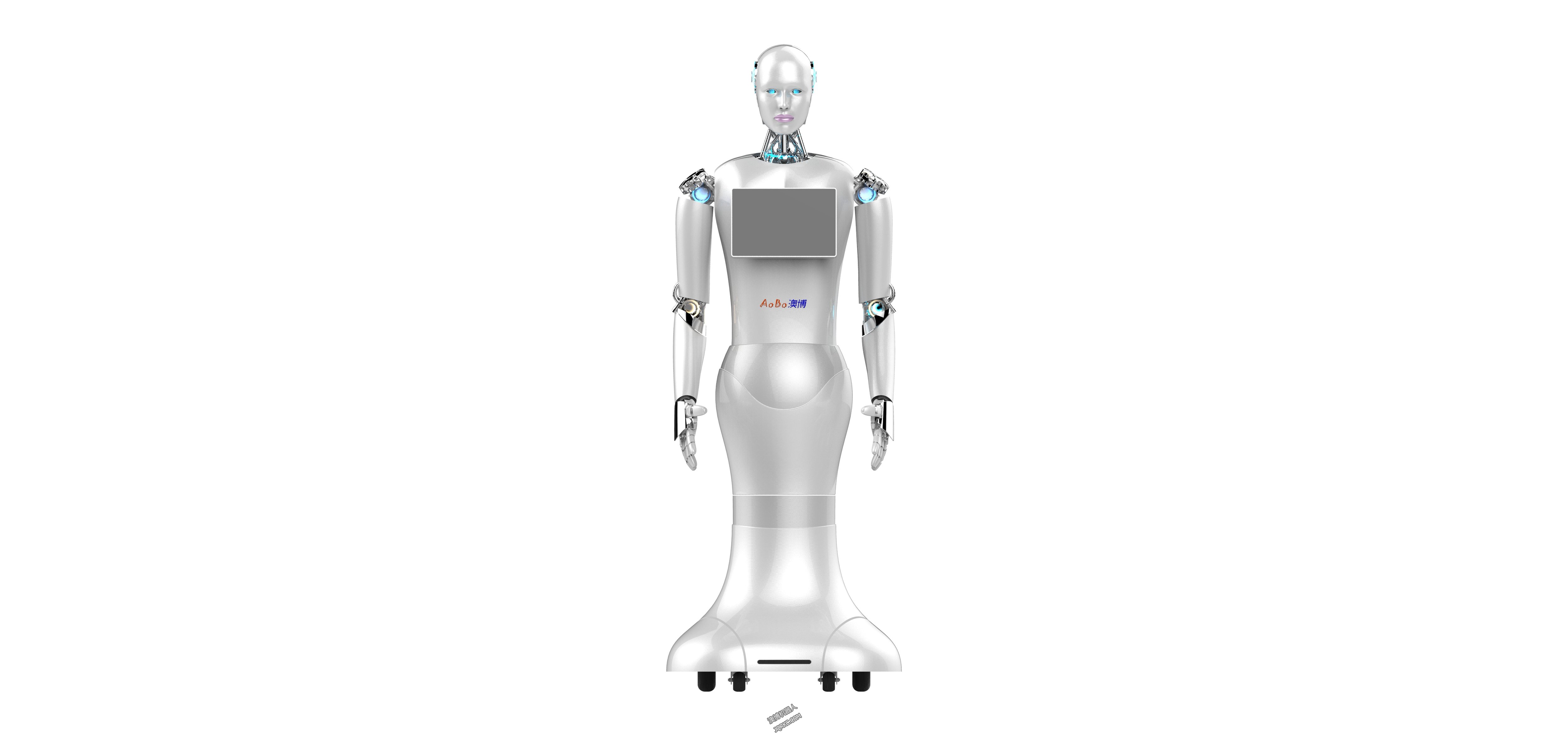

我們更傾向于將機器人和人工智能視為不一樣的實體,但跟著人臉辨認這類軟件不斷添加地被機器人差人所運用,二者之間的鴻溝正變得不再清楚。假設人臉辨認軟件帶有種族主義成見,我們就能創造出種族主義機器人差人,這意味著,我們將不得不對運用人工智能的機器人進行監管。

而假設人工智能也能締造人工智能——好像谷歌在本年I/O大會上展示的一樣——作業將變得更為困難。

終究,要處理這一疑問,需要極點精確的管控方法,以及能夠對黑箱系統進行解說的方法,而這些我們如今都還未能做到。研究者們在陳述中說:“民間關于機器人的法則選擇也仍在極力建立更為慎重、精確的問責制度。”而跟著人工智能的進一步鋪開,疑問將會變得更為嚴重。